Una mappa può essere una copia esatta della realtà?

6 min read

Pierre Simon Laplace, celebre astronomo, fisico, matematico francese del diciottesimo secolo, vedeva la matematica come uno strumento utile per la ricerca scientifica e per risolvere problemi pratici. Egli credeva infatti fermamente nel determinismo causale:

<< Possiamo considerare lo stato attuale dell’universo come l’effetto del suo passato e la causa del suo futuro. Un intelletto che ad un determinato istante dovesse conoscere tutte le forze che mettono in moto la natura […], per un tale intelletto nulla sarebbe incerto ed il futuro proprio come il passato sarebbe evidente davanti ai suoi occhi >>.

Oggi, molti discorsi sull’intelligenza artificiale si fondano sulla quantità di dati su cui questi sistemi lavorano. Spesso si individua un problema complicato e lo si risolve attraverso la raccolta, l’elaborazione e l’analisi di un’enorme quantità di dati. Di fatto, la situazione è analoga a quella descritta da Laplace in cui “l’intelletto” ora è un algoritmo di intelligenza artificiale (AI) che ottiene la sua predizione perfetta quando i dati sono in quantità adeguati. È dunque interessante comprendere a fondo quali siano le caratteristiche di questi sistemi che li rendano così speciali.

Una pubblicità televisiva chiedeva << ti piace vincere facile? >> e mostrava una partita di calcio che vedeva in campo una squadra composta da undici giocatori, come di prammatica, affrontata da una squadra composta da centinaia di giocatori che invadevano la metà campo avversaria come un esercito in guerra. In una simile condizione, poco rileva il confronto sulla tecnica individuale, le strategie di gioco eccetera. Ogni schema salta perché la quantità muta i termini della questione in modo radicale.

Analogamente, la digitalizzazione di un’attività determina un incremento di scala estremamente significativo, tale da sconvolgere il significato originario del lavoro. Una volta che un’attività è dematerializzata e trattata immaterialmente con strumenti digitali, può beneficiare delle diverse proprietà dell’immateriale.

Riprodurre un bene materiale ha un costo non trascurabile, così come immagazzinarlo e manipolarlo; inoltre trasferirlo da un luogo ad un altro presenta costi elevati e richiede tempi lunghi. Di contro, un “oggetto” immateriale può essere trasferito istantaneamente da un capo all’altro del globo con un costo marginale nullo, può essere “manipolato” da un computer e può essere copiato e immagazzinato infinite volte con un costo insignificante.

A ben vedere, quando la possibilità di diffusione delle informazioni era limitata dalla materialità dei supporti, solo pochi soggetti potevano permettersi di creare e gestire dei canali di comunicazione (editori) per i quali era prevista una speciale responsabilità che prevedeva (e prevede), tra l’altro, misure legali specifiche come l’obbligo di rettifica e sanzioni in caso di abuso. D’altro canto, la libertà di espressione dell’individuo, per sua natura confinata a una platea ristretta, era massima. Non poteva estendersi oltre le esternazioni al bar.

Con l’avvento della digitalizzazione, forte delle caratteristiche di rapidità e immaterialità, ecco che si annulla il divario tra la comunicazione individuale (o di gruppo ristretto) e la comunicazione di massa, dove qualunque individuo può raggiungere ad un costo marginale minimo e in tempo reale platee persino più ampie di quelle raggiungibili da un editore. Mentre il sistema regolamentare, che era disegnato per un mondo materiale, si trova messo alle strette per effetto del cambiamento di scala sia della velocità sia della quantità.

L’intelligenza artificiale gioca un ruolo in questo scenario, perché grazie a sistemi di classificazione usati per fare raccomandazioni di lettura, determina la distribuzione e la visibilità dei contenuti e delle interazioni degli utenti.

Un altro esempio di come un cambiamento di scala cambi la natura dell’attività si ha con i cartellini dei fotosegnalati. Le forze dell’ordine, in passato, conservavano materialmente circa 50 mila cartellini di persone che per qualche ragione erano sotto attenzione. Le fotografie fisiche erano raccolte in un archivio assieme a cartelli recanti i dati caratteristici.

In caso di necessità, i dati venivano confrontati con quelli di un sospettato per procedere poi al reperimento della foto. Questa attività è stata digitalizzata e la gara d’appalto per il sistema prevedeva di poter gestire 100 mila cartellini. Una dimensione ritenuta ragionevole dal momento che nelle carceri italiane vi sono circa 60 mila detenuti.

Dato che il costo marginale di elaborazione è contenuto, così come il costo di archiviazione, le ultime notizie ottenute con una richiesta di accesso dicono che, dopo varie iterazioni, il sistema è stato aggiornato con un semplice upgrade hardware (ad un costo pressoché contenuto) ma il numero di soggetti è ora di nove milioni (avete letto bene, circa un sesto della popolazione italiana adulta).

Gestire manualmente 9 milioni di schede è praticamente impossibile. È un po’ come fare manualmente la radice quadrata di 20; ma farlo con un computer, che grazie all’AI può aumentare le nostre funzioni (di sorveglianza in questo caso), è decisamente una cosa fattibile ed economica.

I britannici usano dei furgoni nelle vicinanze di luoghi sensibili che riprendono i passanti a loro insaputa con telecamere nascoste. Le immagini acquisite vengono confrontate in tempo reale con quelle presenti in un database di criminali fotosegnalati; le persone individuate vengono fermate e controllate.

I sistemi che si basano su tecniche statistiche, vanno valutati da due punti di vista, chiamati recupero e precisione. Non si tratta di errori di programmazione o di altro genere bensì di errori inerenti alla tecnica. Esaminando un gruppo di persone che contiene sia criminali sia non criminali, il recupero risponde alla domanda <<quale percentuale dei criminali presenti sono stato in grado di riconoscere?>>. La precisione risponde alla domanda <<quale percentuale di quelli che ho identificato come criminali lo erano realmente?>>.

I due indici sono una coperta corta: aumentando il recupero si riduce la precisione e viceversa. Se fossimo in un regime senza rispetto per i diritti civili, chiaramente si potrebbe tarare il sistema in modo da avere un alto recupero in modo da identificare il più grande numero possibile di criminali. Un sistema così concepito avrebbe il “piccolo” inconveniente che prenderebbe nella rete anche molti innocenti. Viceversa, se si configurasse il sistema per minimizzare o annullare la percentuale di innocenti erroneamente ritenuti criminali, più in linea con i valori democratici, molti criminali non verrebbero riconosciuti.

Tutto questo è possibile grazie ad algoritmi capaci di apprendere, di riconoscere e di decidere. Ma soprattutto grazie ai big data. Si racconta un aforisma attribuito a Stalin: durante la guerra della Russia contro la Germania nazista avrebbe affermato, rispetto al proprio contingente di carri armati – superiori per numero ma inferiori per qualità rispetto ai tedeschi – che << la quantità è una qualità in sé >>.

Tutto sommato è in linea con quello che avviene oggi con le intelligenze artificiali ed è altrettanto in linea con il determinismo di Laplace: la quantità è una qualità.

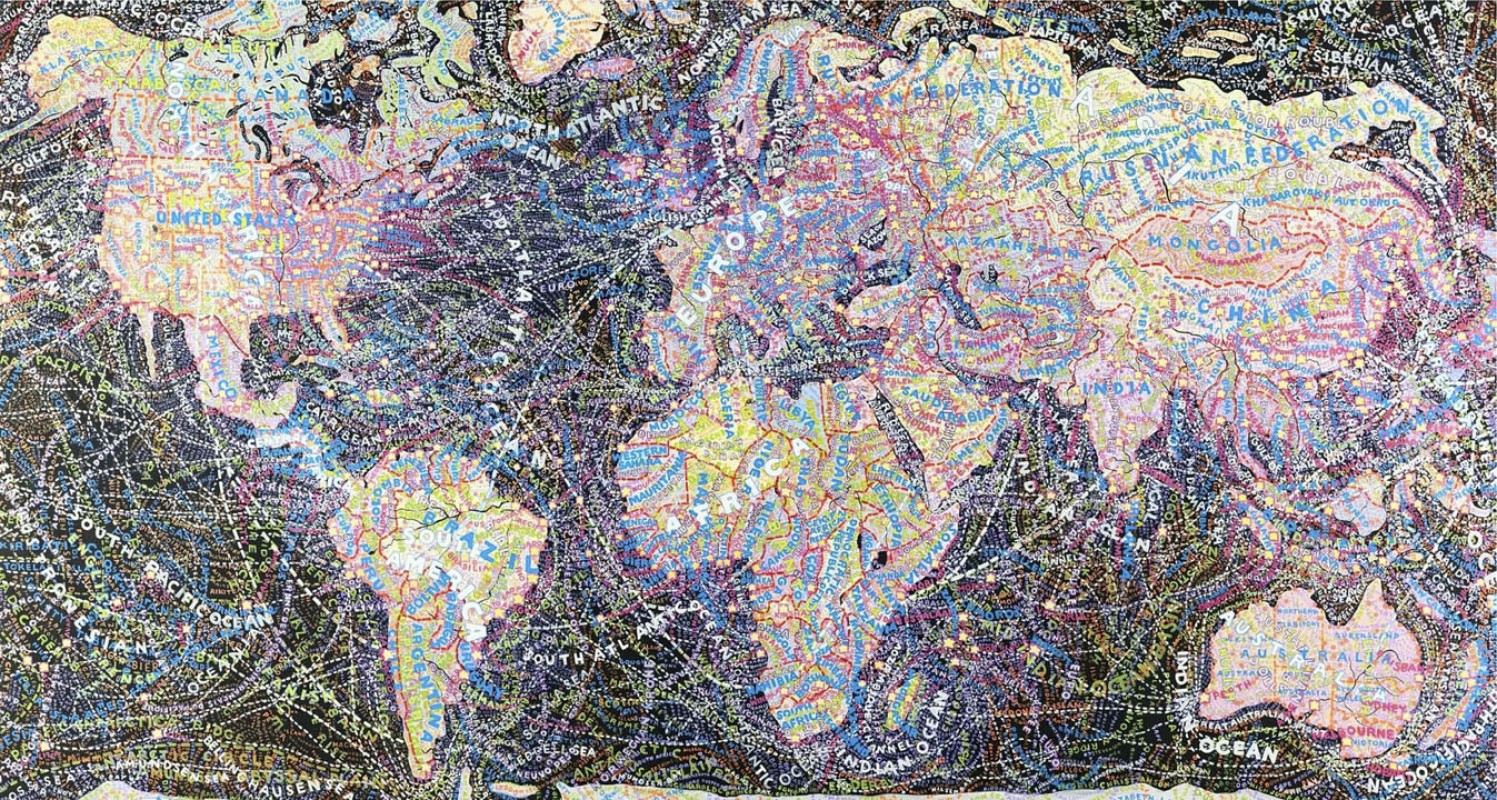

Chi assume questa ipotesi, però, ignora una questione fondamentale. Le intelligenze artificiali operano su dati. I dati sono comprensibili come una mappa della realtà. Un dato è una descrizione elementare, spesso codificata, di un’entità, di un fenomeno, di una transazione, di un avvenimento o di altro. In quanto codifica, il dato è una riduzione della realtà analoga a quello che fa una mappa geografica.

Una mappa è una rappresentazione semplificata dello spazio che evidenzia relazioni tra componenti (oggetti, regioni) di quello spazio. Più in generale, le mappe possono essere usate per rappresentare qualsiasi proprietà locale del mondo o parte di esso, o qualsiasi altro spazio, anche mentale o concettuale. Allora per verificare se sia pensabile un’ipotesi Laplaciana sulle intelligenze artificiali bisogna rispondere a questa domanda: una mappa di dati può essere una copia esatta della realtà?

La risposta è univoca e banale: no. Una mappa che sia un’esatta copia della realtà, qualora fosse teoricamente possibile, di fatto sarebbe inutilizzabile, perché conterebbe troppi dati, al limite infiniti. In questo senso, le intelligenze artificiali sono come le mappe; funzionano e a volte anche molto bene. Non descrivono, però, perfettamente la realtà, poiché esse prendono decisioni sulla base di modelli (recupero e precisione) che sono riduzioni della realtà e mediante dati provenienti da sensori che compiono un’analoga riduzione, hanno al loro interno un fattore di fallibilità.

LINK UTILI:

Inside the urgent battle to stop UK police using facial recognition

I big data ci osservano

Sono un ricercatore presso Co.Mac – CFT, un importante gruppo italiano che opera nell’ambito degli impianti industriali. Laureato in ingegneria Meccanica con specializzazione in Meccatronica al Polimi. Attualmente studio automazione con particolare focus verso gli algoritmi di intelligenza artificiale e le sue applicazioni nel mondo reale.

Comunicare significa donare parte di noi stessi, ed è questo il motivo per cui la divulgazione scientifica è una delle mie più grandi passioni.