Il muro del significato

5 min read

L’intelligenza artificiale si sta via via affermando per la sua indiscutibile capacità di rispondere alla difficoltà di capire da sé, grazie a tonnellate di esempi (big data), diventati disponibili per via della digitalizzazione continua, la realtà. Ci sono sempre più dati disponibili su tutto; e questa condizione è stata trampolino di lancio dell’approccio statistico. Di contro, uno degli svantaggi tipici dei sistemi statistici è la necessità di addestramento per una quantità sterminata di dati prima di arrivare a regime.

Se la questione relativa all’apprendimento può essere affrontata aumentando i dati disponibili durante la fase di training dell’algoritmo, vi è un aspetto chiave intrinseco all’intelligenza artificiale difficile da risolvere: capire come il sistema sia giunto ad una determinata conclusione. Si chiama infatti “black box”, scatola oscura, e il deep learning è il modello per eccellenza più affetto dalla sindrome dell’incomprensibilità.

Immaginiamo un software che si pronunci su una diagnosi medica: “in base alle mie analisi, il paziente ha un tumore” oppure “Quel tumore non è operabile”.

Come possiamo fidarci della sua conclusione se non possiamo sapere come è sopraggiunto ad una tale decisione? Su che cosa si è basato? In aggiunta, un sistema non trasparente non è facilmente accessibile. Non lo si può neppure sottoporre ad un vaglio di terze parti. È un po’ come se un tribunale emettesse una condanna in tutta segretezza in base a criteri impliciti (non riportati da nessuna parte) e senza che l’opinione pubblica possa esercitarvi un controllo. Ciò equivarrebbe a violare i principi che sono alla base di uno stato di diritto e di una democrazia.

La non trasparenza rende più difficile anche la difesa degli algoritmi dai bias, cioè pregiudizi che, assimilati dai dati, possono acuire discriminazioni anche sociali. Si pensi ad esempio a sistemi che decidano quale retribuzione dare ai dipendenti e le stabiliscano sempre inferiori per le donne (semplicemente perché le donne sono statisticamente e storicamente pagate di meno). Infine, un sistema non trasparente è più soggetto a subire attacchi di chi vuole boicottarne il funzionamento, perché i ricercatori non possono analizzarne i processi per trovare errori e vulnerabilità.

Tutti questi motivi stanno spingendo sempre più la comunità scientifica a riconoscere che, per essere utilizzati in alcuni ambiti ad alto rischio, i sistemi AI debbano avere un comportamento verificabile e spiegabile.

Alcuni limiti dei sistemi digitali risaltano se facciamo un confronto con l’intelligenza umana. Se mostriamo un libro ad un bambino che non ne ha mai visto uno, gli basterà quella sola volta per riconoscere, da quel momento in poi, tutti i libri. L’algoritmo ad apprendimento automatico, invece, richiede centinaia di migliaia di immagini per imparare a riconoscere un libro

Un altro limite è l’incapacità di fare inferenze basate su conoscenze pregresse. Quando leggono un testo, gli esseri umani tendono a trarre inferenze ad ampio raggio per arrivare a possibili interpretazioni. Questo perché siamo dotati di quella (magica) capacità di richiamare la conoscenza da domini molto diversi e applicarla al testo.

L’AI non ci riesce ed il motivo di fondo è che non ha una reale comprensione del concetto di “libro”. Esegue una miriade di calcoli da cui arriva a conclusioni probabilistiche. Di conseguenza, un tale sistema è incline a compiere errori molto sciocchi quando si imbatte in nuovi scenari, dove i dati sono per qualche motivo insufficienti o affetti da “rumore” statistico.

Tutti gli incidenti capitati finora alle auto a guida autonoma sono avvenuti in situazioni molto inusuali: un pedone che spinge un carrello un po’ fuori dalle strisce, un auto ferma sulla sinistra in autostrada o un anziano che pedala una bici al buio.

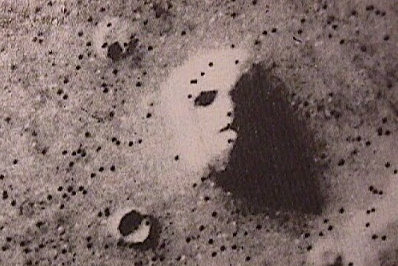

Questa è una foto della superficie di Marte scattata dalla Nasa. Sebbene si tratti di un cratere, gli attuali sistemi di AI lo identificherebbero con un volto umano. Per non cadere nell’errore, l’AI dovrebbe dare per assunto un dato che per noi è scontato, ma non lo è per l’algoritmo: su Marte non ci sono esseri umani.

Tutto questo può portare a conseguenze disastrose in applicazioni critiche, come appunto la guida autonoma o la gestione di una centrale nucleare. Decidere solo in base a correlazioni statistiche implica la possibilità di arrivare ad agire in modi che per un uomo sono inaccettabili (investire un bambino per esempio).

In un recente articolo del New York Times, Melanie Mitchell (università di Portland), dopo aver passato in rassegna un certo numero di flop semantici dei sistemi di deep learning, conclude: “Per sviluppare un AI affidabile dovremmo fare un’indagine più approfondita sulle straordinarie abilità dell’intelligenza umana e capire meglio i meccanismi cognitivi che noi stessi usiamo per comprendere il mondo con efficacia”.

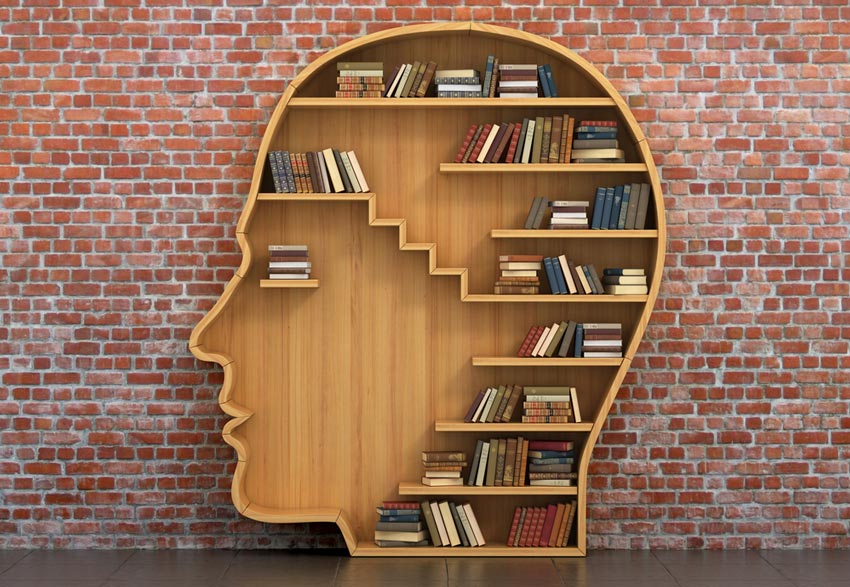

Dietro a queste parole c’è un problema enorme che i filosofi del linguaggio e delle scienze cognitive chiamano muro del significato. Noi esseri umani non abbiamo una teoria univoca del significato (ne abbiamo troppe, in conflitto tra loro). Ci capiamo ma non sappiamo il perché: il significato accade, semplicemente. L’AI, invece, non possiede il significato delle cose, a differenza di noi esseri umani che sembriamo possederlo in modo innato.

Le attuali tecniche neurali non possono rendere conto della semantica, cioè del rapporto tra parole e realtà. Ecco perché quando si tratta di intendersi con l’essere umano per eseguire una procedura, ricercare un’informazione complessa o risolvere un problema, le macchine hanno bisogno di rifornirsi di esempi linguistici, dove le espressioni sono innate con qualcosa che rimanda a concetti e relazioni.

Ad un bambino invece basta vedere una o due volte come si grattugia il formaggio e sa subito farlo, potrebbe anche riuscire ad intuirlo da solo. Questa capacità “istintiva” (o contestuale) è tutt’oggi una caratteristica umana ed è anche il collo di bottiglia che frena lo sviluppo di questi sistemi.

Secondo le teorie più accreditate, infatti, nelle scienze cognitive, la nostra intelligenza è sempre più “situata” nel nostro corpo, nell’ambiente e nell’azione che intendiamo compiere. Ciò che chiamiamo intelligenza artificiale, invece, no. Ed è per questo che a volte commette errori assurdi (che un essere umano non farebbe) o richiede un addestramento lunghissimo di cui un umano non avrebbe bisogno.

Io stesso che scrivo queste righe, lo faccio consapevole del fatto che il lettore comprenda le mie parole. Ma se dovessi giustificare questa mia certezza, mi troverei in difficoltà. In realtà, nessuno può fornire una spiegazione scientifica del perché voi state capendo ciò che scrivo. E non è neanche chiaro cosa si debba esattamente intendere per comprensione, cioè quale sia il significato del “significato”.

Se vogliamo un AI più efficiente, soprattutto per comprendere il linguaggio naturale e comunicare meglio con noi, superare il muro del significato può risultare necessario.

LINK UTILI:

We shouldn’t be scared by superintelligent AI

Cognizione incorporate

Sono un ricercatore presso Co.Mac – CFT, un importante gruppo italiano che opera nell’ambito degli impianti industriali. Laureato in ingegneria Meccanica con specializzazione in Meccatronica al Polimi. Attualmente studio automazione con particolare focus verso gli algoritmi di intelligenza artificiale e le sue applicazioni nel mondo reale.

Comunicare significa donare parte di noi stessi, ed è questo il motivo per cui la divulgazione scientifica è una delle mie più grandi passioni.