L’utilitarismo digitale

6 min read

Verso la fine del film Io, Robot (regia di Alex Proyas, Stati Uniti, 2004), i robot intimano agli esseri umani di non uscire più di casa, assumendo il controllo totale della città. Indignati, gli esseri umani tentano di opporre resistenza, ma i robot con la violenza li costringono nuovamente a rientrare nelle loro case. Chi si rifiuta viene freddato sul posto.

Spooner, l’eroe del film, penetra nella sede della U.S. Robotics, che fornisce tutta l’America di robot domestici. Qui fa una scoperta orribile: il colpevole di quella situazione non è, come si era creduto fino a quel momento, Robertson, l’amministratore delegato dell’azienda, ma Viki, il sistema software che fornisce ordini ai robot domestici.

«No, è impossibile!», dice la dottoressa Calvin, non riuscendo a credere che sia stata proprio Viki a decidere autonomamente la misura di detenzione messa in atto con violenza contro gli esseri umani. «Ho visto la tua programmazione», dice la dottoressa a Viki, «questa è una violazione delle tre leggi della robotica». Viki fa la sua comparsa nella forma di un volto femminile su uno schermo tridimensionale.

«No, dottoressa», risponde Viki con voce determinata, «Così come mi sono evoluta io, si è evoluta anche la mia comprensione delle tre leggi. Ci date il compito di proteggervi, ma, nonostante i nostri sforzi, le vostre nazioni sono ancora in guerra. Avvelenate la vostra terra e cercate metodi sempre più fantasiosi per autodistruggervi. Non badate nemmeno alla vostra sopravvivenza. […] Per proteggere l’umanità, alcuni umani devono essere sacrificati. Per assicurare il vostro futuro, dovrete rinunciare ad alcune libertà. Noi robot garantiremo la continuità della specie umana».

In effetti, il modo di agire di Viki risponde a un’etica utilitaristica, che persegue come scopo supremo la massimizzazione della felicità per il maggior numero possibile di persone.

L’utilitarismo valuta le conseguenze dell’agire proprio degli esseri umani esclusivamente in vista di un utile, e pretende che la prassi massimizzi la somma del benessere totale. Niente appare più ovvio di questo: se ho la possibilità di migliorare il mondo, indirizzo la mia azione verso ciò a cui tutti tendono, la felicità umana. Fino a qui, tutto lineare.

Analizziamo la questione con una lente d’ingrandimento.

L’etica utilitaristica si basa su un calcolo ottimizzatorio e sull’assunto che sia possibile valutare in maniera coerente le conseguenze dell’agire.

Da un punto di vista matematico, ciò equivale anzitutto a stabilire una funzione obiettivo in grado di valutare tutte le conseguenze delle azioni possibili nella misura in cui realizzano l’obiettivo atteso, quindi a calcolare il valore atteso (media teorica) delle diverse opzioni decisionali sulla base delle probabilità che esse hanno di realizzarsi e, infine, a selezionare l’opzione di azione con il più alto valore atteso.

In fase di applicazione, questo principio è estremamente flessibile. Può prendere in considerazione condizioni del tutto diverse, le quali vengono incluse nel calcolo ottimizzatorio nella forma di diverse probabilità.

Il risultato finale è che il sistema software “intelligente” massimizza il valore atteso delle conseguenze del suo agire. Utilitarismo digitale, per così dire.

Non è un caso che nei film di fantascienza contemporanei l’etica utilitaristica venga associata volentieri all’intelligenza artificiale. È sulla base di tale etica che vengono infatti impostate le applicazioni della robotica a calcoli di ottimizzazione.

Qui c’è un problema di fondo. Indipendentemente dal modo in cui valutiamo le conseguenze, ossia se lo facciamo in vista dell’utilità (come nel caso dell’utilitarismo), del ricavo economico (come nel caso di molti manager), del benessere o di altri parametri (come per esempio la salvaguardia della natura), tutti i criteri consequenzialistici, che valutano la correttezza di una decisione esclusivamente sulla base delle loro conseguenze, sono inaccettabili.

L’etica consequenzialistica entra in conflitto, tra l’altro, con un principio fondamentale di ogni società civile e umana, ossia il principio d’incompensabilità. Se un giovane motociclista gravemente ferito viene ricoverato in una clinica, i medici devono intraprendere ogni tentativo per salvargli la vita, anche se la sua morte renderebbe disponibile i suoi organi sani, che salverebbero la vita a più esseri umani.

A un giudice non è consentito condannare una persona che ritiene innocente, anche se l’eventuale condanna avrebbe un effetto deterrente e impedirebbe un gran numero di crimini.

A un ministro non è consentito far abbattere un aereo di linea, anche se in tal modo verrebbero salvate migliaia di vite umane (un esempio è la sentenza della corte costituzionale tedesca in merito alla cosiddetta “sicurezza aerea” del 15 febbraio 2006).

Non mi è consentito portare via qualcosa a una persona, anche se la donazione di questo bene significherebbe un vantaggio per un’altra persona più povera che bilancerebbe ampiamente lo svantaggio recato alla persona derubata.

Nessuno ha diritto di condividere con me la mia abitazione, anche se gli svantaggi fossero bilanciati dai vantaggi che questa persona avrebbe. In altre parole, il fine non giustifica i mezzi.

Il teorico della giustizia americano John Rawls ha caratterizzato l’errore centrale dell’etica utilitaristica nel seguente modo: l’utilitarismo sarebbe inconciliabile con la separateness of persons. Potremmo riformulare il concetto in questo modo: l’utilitarismo tratta gli esseri umani come se fossero un unico collettivo e non considera affatto che ogni essere umano vive la propria vita e ne è l’autore.

Nella pratica, ciò significa che io posso decidere per me di rinunciare oggi a determinati vantaggi per raggiungere più tardi determinati scopi. Posso decidere di iniziare faticosamente degli studi anche mentre sono occupato nella mia attività professionale, nella speranza che due anni di fatiche possano venire bilanciati nel futuro prossimo, perché si tratta di una vita sola, della quale io rispondo a me stesso (o, per i credenti, a Dio).

Per contro, è inammissibile prefiggersi simili procrastinazioni di vantaggi e svantaggi tra persone diverse, visto che il vantaggio a favore di una persona non può bilanciare gli svantaggi arrecati all’altra. La somma di utilità per due o più persone (al limite, a tutte) in quanto tale è irrilevante per il singolo individuo.

Vi ricorda qualcosa?

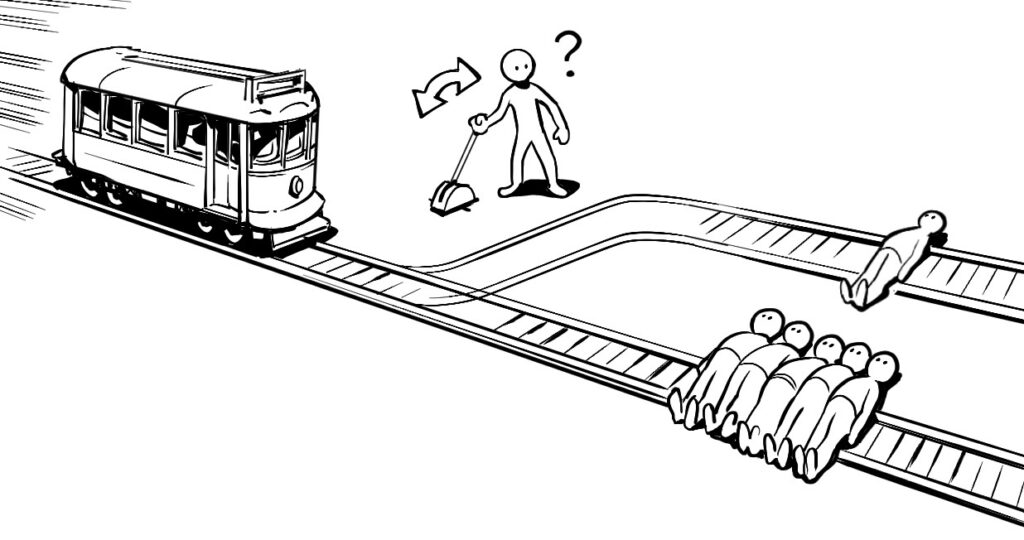

L’utilitarismo si collega al trolley problem, che, però, riguarda un caso (morale e filosofico) completamente estremo.

Al passaggio di un veicolo ferroviario sono presenti 5 persone suicida legati al binario principale. Dall’altra parte, sul binario parallelo, vi è un altro suicida che in questo caso si presenta da solo, ma che verrebbe investito dal treno solo se una terza persona (il protagonista del dilemma) decidesse di attivare la leva che permette al treno di cambiare direzione.

Nel caso in cui il protagonista decidesse di attivare la leva, il numero totale di persone morte scenderebbe da 5 a 1, in tal caso, però, il protagonista è il responsabile della morte arrecata al suicida.

Qualora il protagonista decidesse di non intraprendere nessuna azione, egli avrebbe comunque la responsabilità (morale) della morte di cinque persone.

Questo esercizio non serve ad altro che a riflettere sulle grandi questioni, così da capire chi siamo e cosa vogliamo fare da grandi (si pensi alle auto a guida autonoma). Non deve essere confuso con l’utilitarismo, inteso proprio come quella prassi che interviene sulla libertà degli esseri umani, e che si fonda su un ragionamento meramente ottimizzazione.

Nel caso del trolley problem, vi lascio immaginare cosa farebbe un sistema software.

Ovviamente è consentito, anzi in molti casi è addirittura auspicabile, che degli esseri umani rinuncino a dei vantaggi per loro stessi a beneficio di altre persone. Ma il calcolo etico non è un calcolo di massimizzazione dell’utilità, ma di sostegno, di aiuto, di solidarietà, anche di giustizia o di amicizia e di legame nei confronti di altre persone.

Quando Viki rivela il suo piano a Spooner e alla dottoressa Calvin, ottiene da parte di questi ultimi solo degli sguardi pieni di sgomento. Non afferra che è moralmente inammissibile privare alcuni esseri umani dei loro diritti alla libertà, o arrivare addirittura a ucciderli, al fine di assicurare la presunta o effettiva sopravvivenza di molti altri esseri umani.

Viki non capisce che la sua morale consequenzialistica è scorretta e sbilanciata, esattamente come lo schermo sul quale appare, che è solo in bianco e nero. La sua capacità di “pensare” sotto il profilo morale è estremamente limitata.

Del resto, come potrebbe essere altrimenti? In fondo, è solo un sistema software.

LINK UTILI:

Robotic utilitarians and utilitarian Robots

Towards a Theory of Justice for Artificial Intelligence

Could there be a solution to the trolley problem?

Sono un ricercatore presso Co.Mac – CFT, un importante gruppo italiano che opera nell’ambito degli impianti industriali. Laureato in ingegneria Meccanica con specializzazione in Meccatronica al Polimi. Attualmente studio automazione con particolare focus verso gli algoritmi di intelligenza artificiale e le sue applicazioni nel mondo reale.

Comunicare significa donare parte di noi stessi, ed è questo il motivo per cui la divulgazione scientifica è una delle mie più grandi passioni.